电力容量与AI的未来

人工智能在逐渐演变成完整的工业生态系统的同时, 也正在逐渐增加消耗前所未有的电力。无论是生成式模型、大型语言模型(LLM),还是多模态智能体,它们在数据中心的运行都依赖于一个共同支柱:电力容量。在人工智能飞速发展的背后,能源消耗问题也日益凸显,成为业内关注的焦点。甚至有人提出,“AI的尽头是算力,而算力的尽头是电力”。

随着模型规模不断扩大、实时推理需求持续上升,AI行业面临着新的问题不“我们是否有足够的电力来驱动它们”?

AI电力需求的指数式增长

根据国际能源署(IEA)的预测,到2030年,全球数据中心的用电量预计将翻倍,达到每年约945太瓦时(TWh)。其中,为AI优化的高性能数据中心的电力消耗可能是当前的四倍,相当于在全球电网中增加一个中等发达国家的全年电力需求。就功耗而言,传统数据中心的规模可能在10-25兆瓦(MW)左右。超大规模、专注于人工智能的数据中心的容量可达100兆瓦或更高,每年的用电量相当于10万户家庭的用电量。以人工智能为中心的数据中心的规模正在不断扩大,以容纳越来越大的模型和日益增长的人工智能服务需求。

2020年,GPT-3训练耗电约300兆瓦,而在GPT-5生成约1000个tokens的中等长度回答,平均消耗18.35 瓦时(相当于运行微波炉约76.46秒),最高可达40瓦时,远超其前代产品GPT-4的2.12瓦时,增幅约为8.6倍。每一代新模型,尤其是参数规模超过千亿的大模型,都需要更长的训练周期、更高密度的GPU集群,以及持续高负载的电力供给。当前AI模型的发展还是在比拼规模化,模型的规模越来越大,所需的GPU计算集群密度增加,耗电量的需求也极具的成倍增长。简而言之,电力已成为新的计算货币。

电力容量如何塑造AI的发展

“速度即电力”成为竞争核心指标。在全球AI基础设施竞赛中,Speed-to-Power,即数据中心接入稳定电力的速度,已成为决定胜负的关键。 即便土地、冷却系统和网络带宽都具备,若电网接入延迟,AI部署仍将被迫停滞。

电力生产与传输基础设施的扩张极为缓慢。从规划、审批到建成投运往往需数年,而AI的需求几乎以季度为单位增长。公用事业单位面临如何在保障民用与工业供电的同时,为AI数据中心分配可持续电力的双重挑战。 美国是世界AI数据中心最集中占比最大的国家,但其部分地区因AI带来的新增负荷,已接近电网安全阈值。

AI训练任务会在极短时间内引发高强度功率激增,给地方电网带来巨大压力并增加不稳定风险。特别是在超大型的AI数据中心有大型GPU集群同时开启时,可能会导致电网电压波动,尤其是在与可再生能源并网的系统中。因此AI的基础建设里电力还有很多待优化,补充的地方。

如何弥合电力缺口

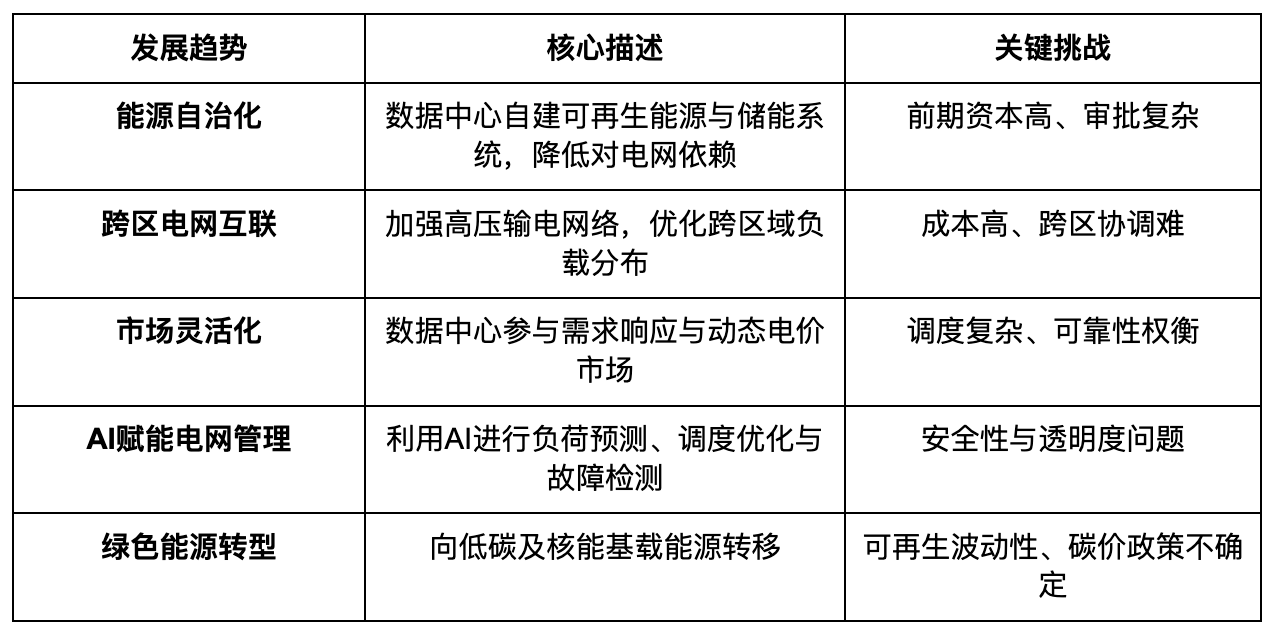

AI对电力的消耗增长已成为企业面临的核心挑战之一。随着电力供应成为AI发展的关键因素,越来越多企业开始通过内部优化与多元能源策略来增强应对能力,减少对外部电网扩容或政策支持的依赖。

首要方向是能效提升与算力优化。通过模型压缩、稀疏计算、量化推理、动态调度等手段,AI企业正努力让每一瓦电力产出更多计算结果。同时,数据中心的硬件架构也在革新液冷、高密度机柜设计等方案,使PUE(能源利用效率指标)持续下降。

其次是能源多元化与储能建设。许多AI基础设施运营方已不再完全依赖公共电网,而是部署分布式发电与储能系统,如园区级光伏、风能和BESS电池储能,通过削峰填谷平衡负载并增强能源弹性。

此外,智能电力管理系统正成为行业新标配。AI驱动的能源监测平台可实时追踪算力集群功率波动,预测电力峰值并自动调整供能策略,实现算力调度与能耗管理的双重优化。最后,企业间协作也在兴起。大型AI公司与能源供应商正共同投资新型电力基础设施,签订长期购电协议(PPA),推动绿色电力直采和区域能源互联。

总体而言,AI行业的重心正在从单纯扩容算力,转向追求“更聪明的能耗”即在电力有限的世界中,用更高的效率支撑更强的智能。

电力从资源到战略资产

如今,电力容量已不仅是技术参数,而是连接数字创新、工业政策与能源转型的战略杠杆。

未来的AI竞争,将不仅比拼算力和算法,而是比拼谁能更快、更稳、更绿色地获得电力。

结语

当行业仍在讨论如何满足AI的电力需求时,Bitdeer AI已开始行动。我们计划在2026年前将AI专用电力容量扩大至200兆瓦(MW),以支撑遍布东南亚及美国和挪威等覆盖全球的高性能GPU数据中心网络。这一目标不仅代表规模增长,更是我们建设高能效、AI原生基础设施的战略蓝图。通过200 MW的电力扩展计划,Bitdeer AI不仅在扩大计算规模,更是在为下一代智能基础设施奠定电力基础。

随着全球AI需求的急剧增长,电力容量正从约束条件变为机遇焦点。AI的下一个突破,不仅取决于更强的芯片与算法,也取决于谁能在全球范围内提供稳定、高效、可持续的电力支撑。