基于Bitdeer AI Cloud 上安装与配置 OpenClaw指南

OpenClaw 是一个功能强大的 AI Agent 框架,可用于构建具备多种能力的智能助手,支持 Web 搜索、代码执行以及与多种 AI 模型的集成。基于 Bitdeer AI Cloud,OpenClaw 可在云端部署,支持灵活的资源配置与按使用量计费模式,团队无需长期硬件投入即可高效运行 AI Agent。

本文将详细介绍如何在 Bitdeer AI Cloud 上部署 OpenClaw,并完成相关配置,通过实际示例展示如何构建一个可交互、可持续运行的 AI 助手服务。

前置条件

在开始部署前,请确保已具备以下条件:

- 一个有效的 Bitdeer AI Cloud 账号

- 基本的 Linux 命令行操作经验

- 一个 Telegram 账号(用于 Bot 集成)

步骤一:创建 Bitdeer AI Cloud 实例

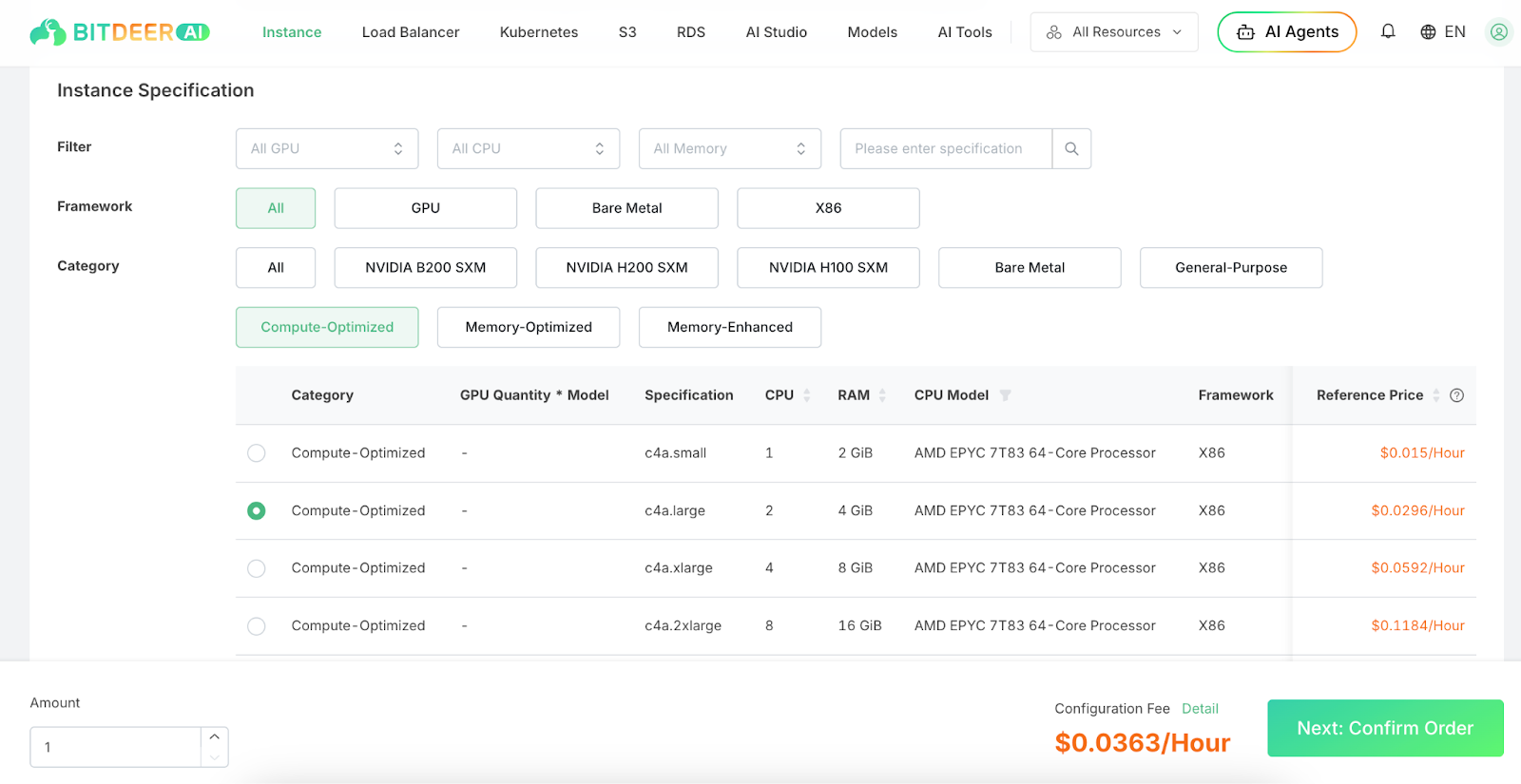

订购虚拟机实例

登录 Bitdeer AI Cloud 控制台,创建并订购一个新的虚拟机实例。

推荐实例配置如下:

- CPU:不少于 2 核

- 内存(RAM):至少 4 GB

- 存储:不少于 20 GB SSD

- 操作系统:Ubuntu 20.04 或更高版本

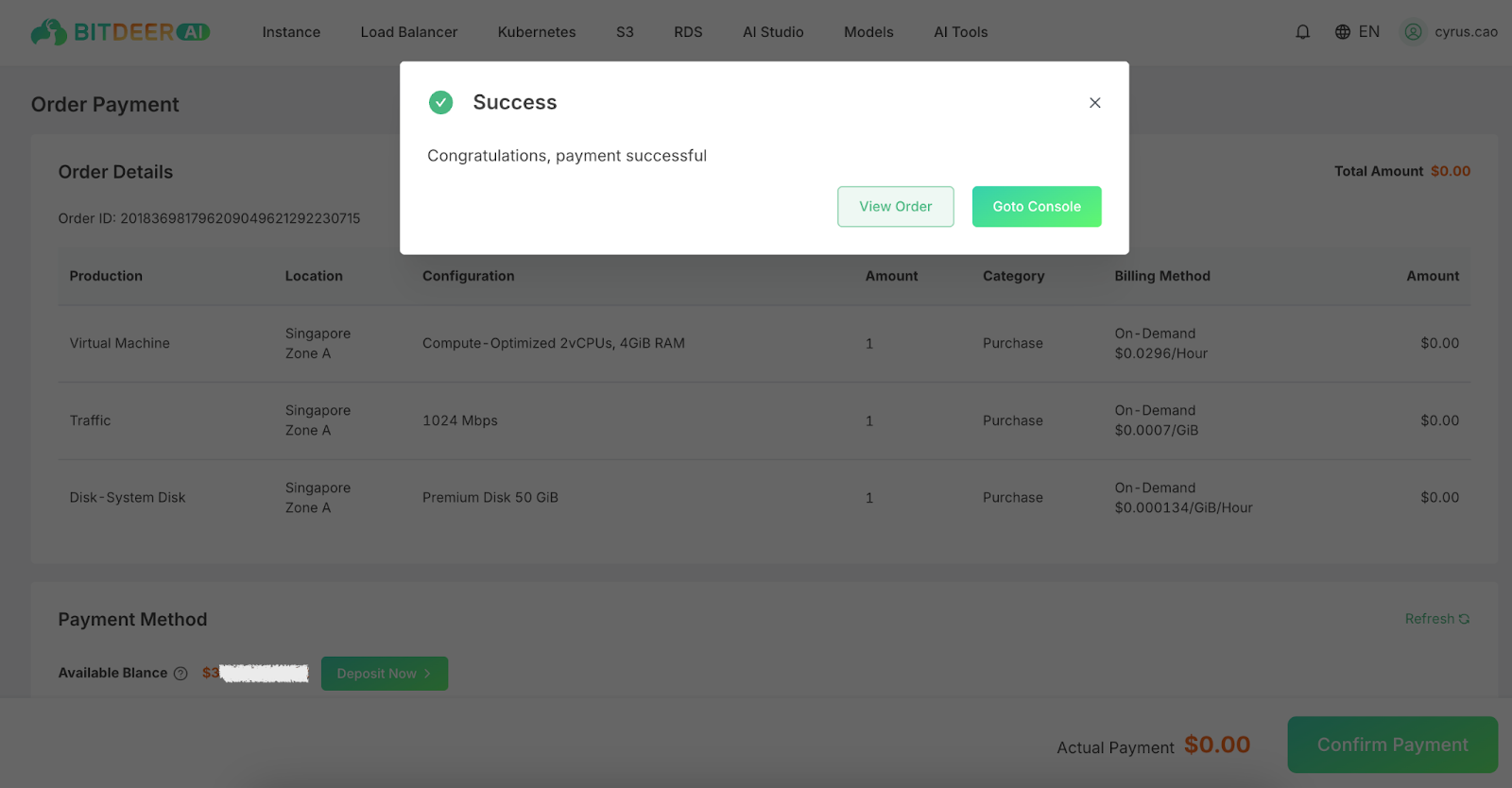

提交订单后,请等待实例完成自动部署。

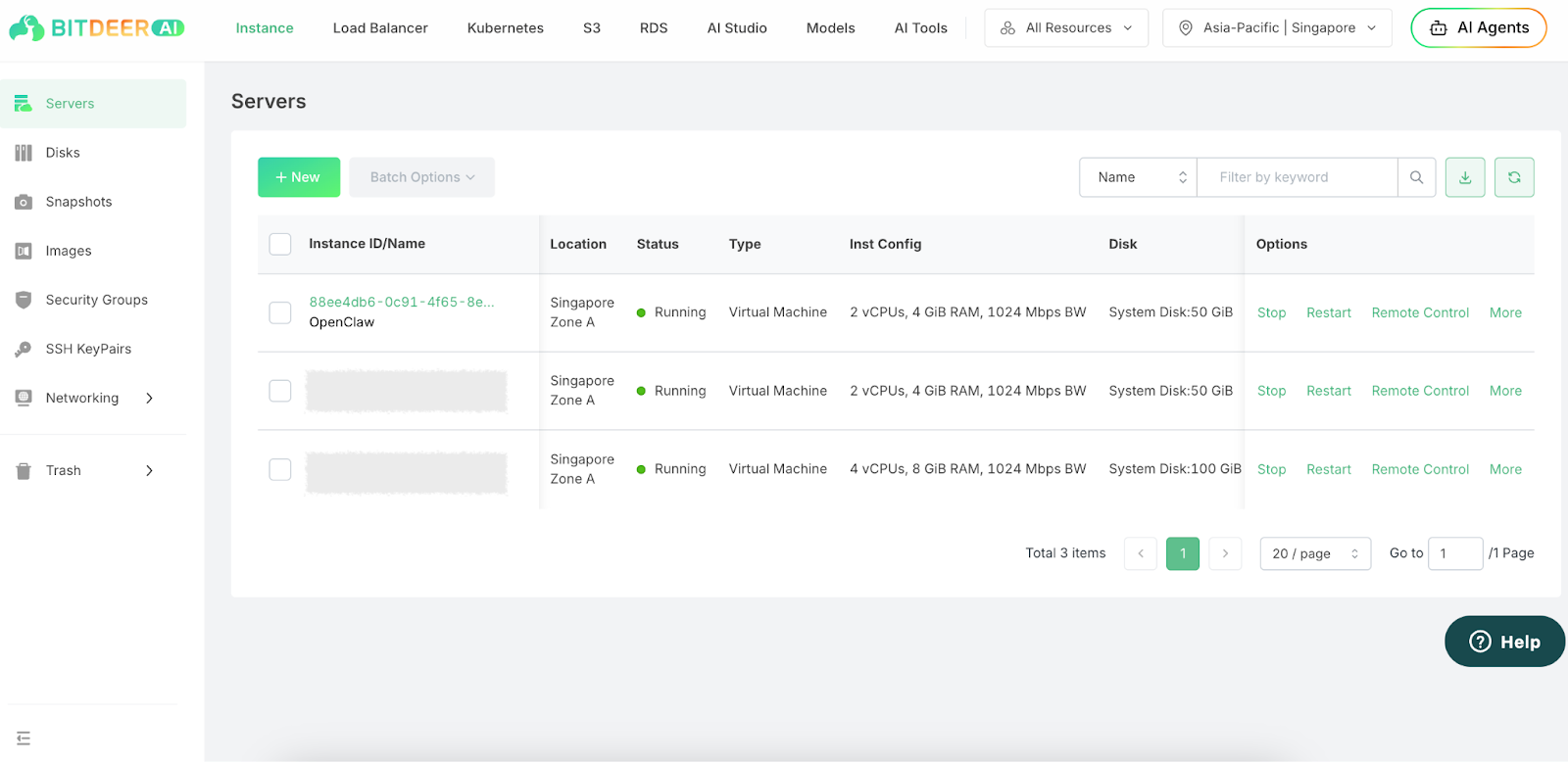

访问实例

实例状态变为 Running 后,即可通过 SSH 方式连接到服务器:

ssh username@your-instance-ip

步骤二:安装 OpenClaw

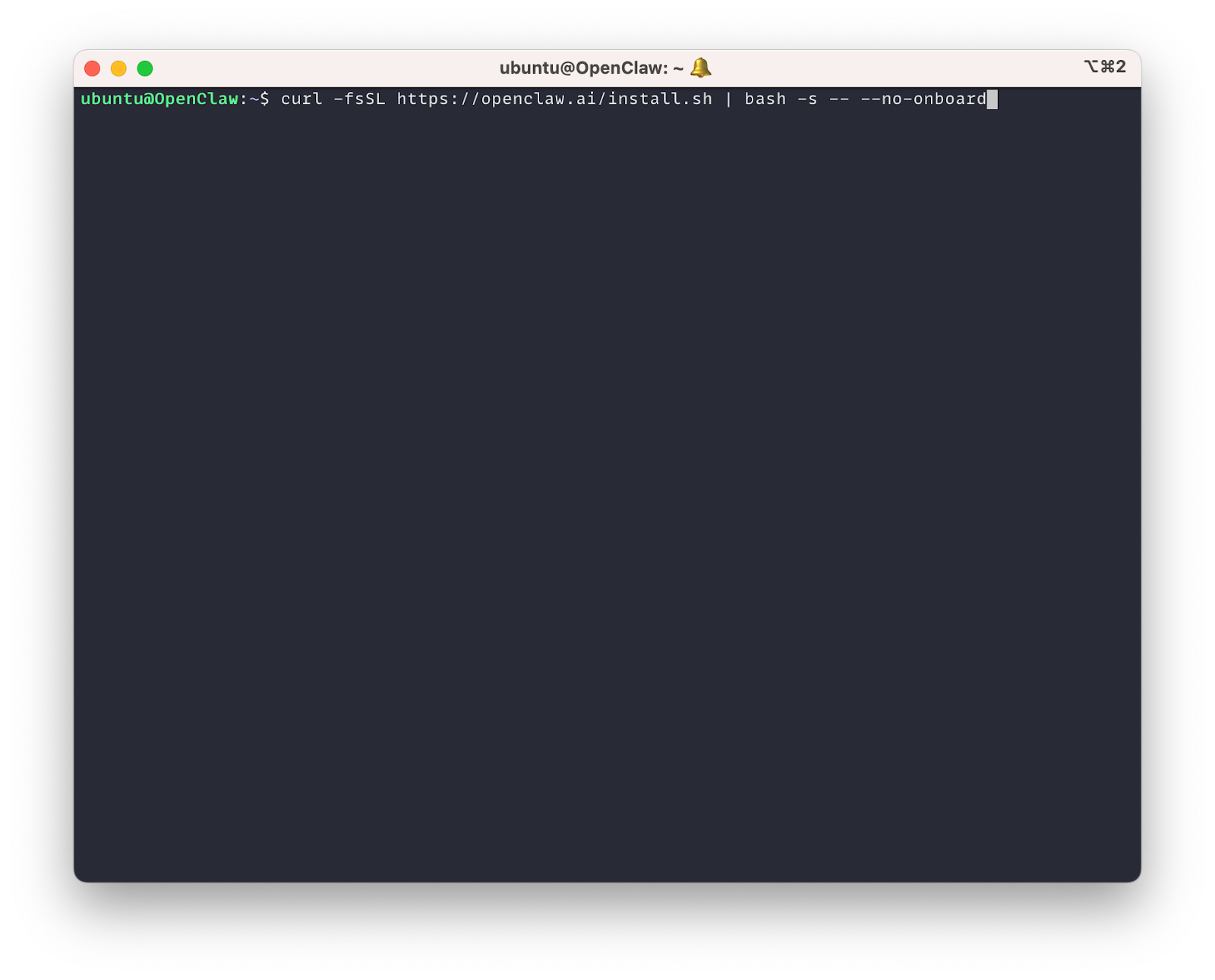

快速安装

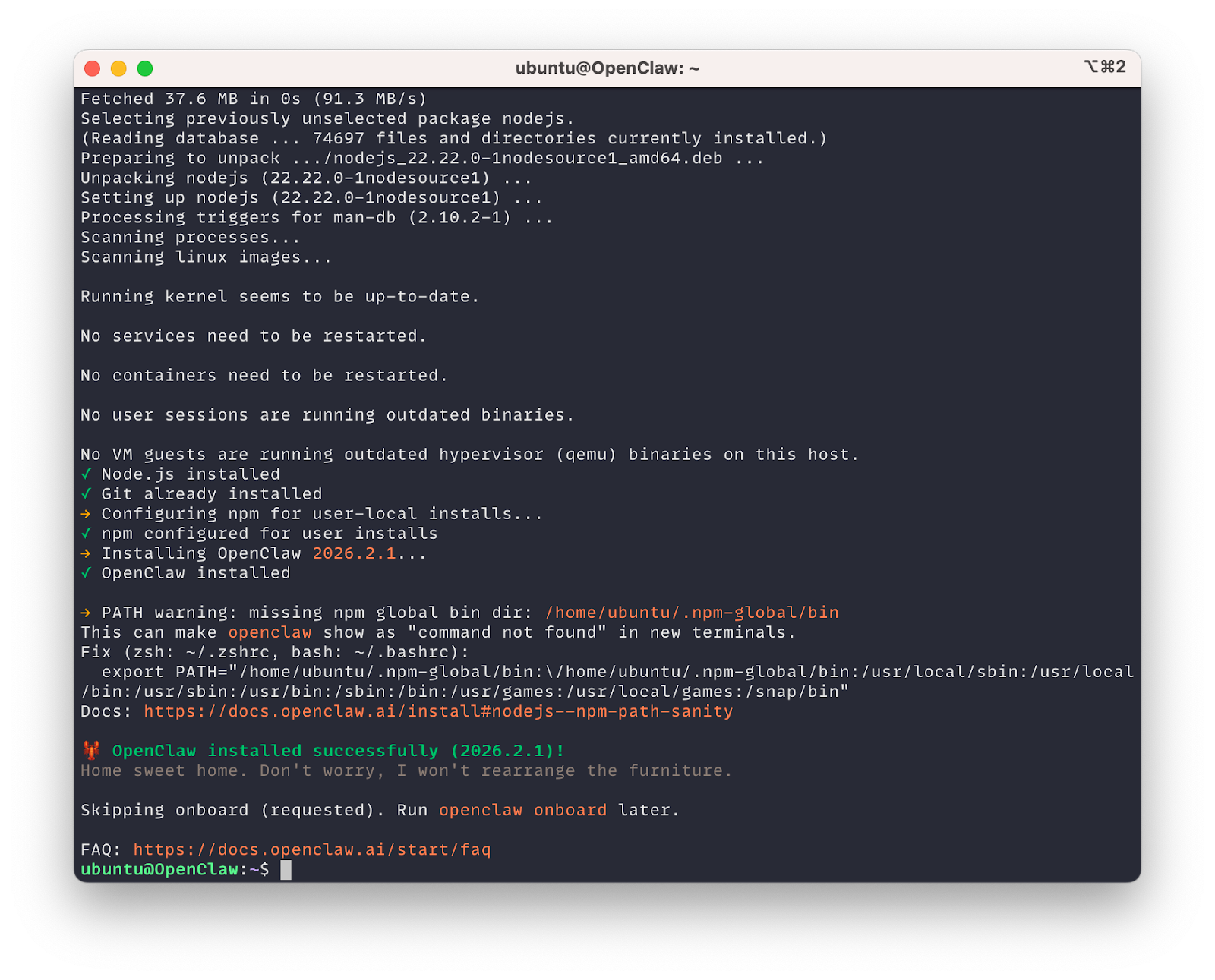

OpenClaw 提供了一行式安装脚本,可自动处理全部依赖项。请在服务器终端中执行:

curl -fsSL https://openclaw.ai/install.sh | bash -s -- --no-onboard

该命令将自动完成以下操作:

- 安装所需的系统依赖

- 配置 Node.js 运行环境

- 安装 OpenClaw 主程序

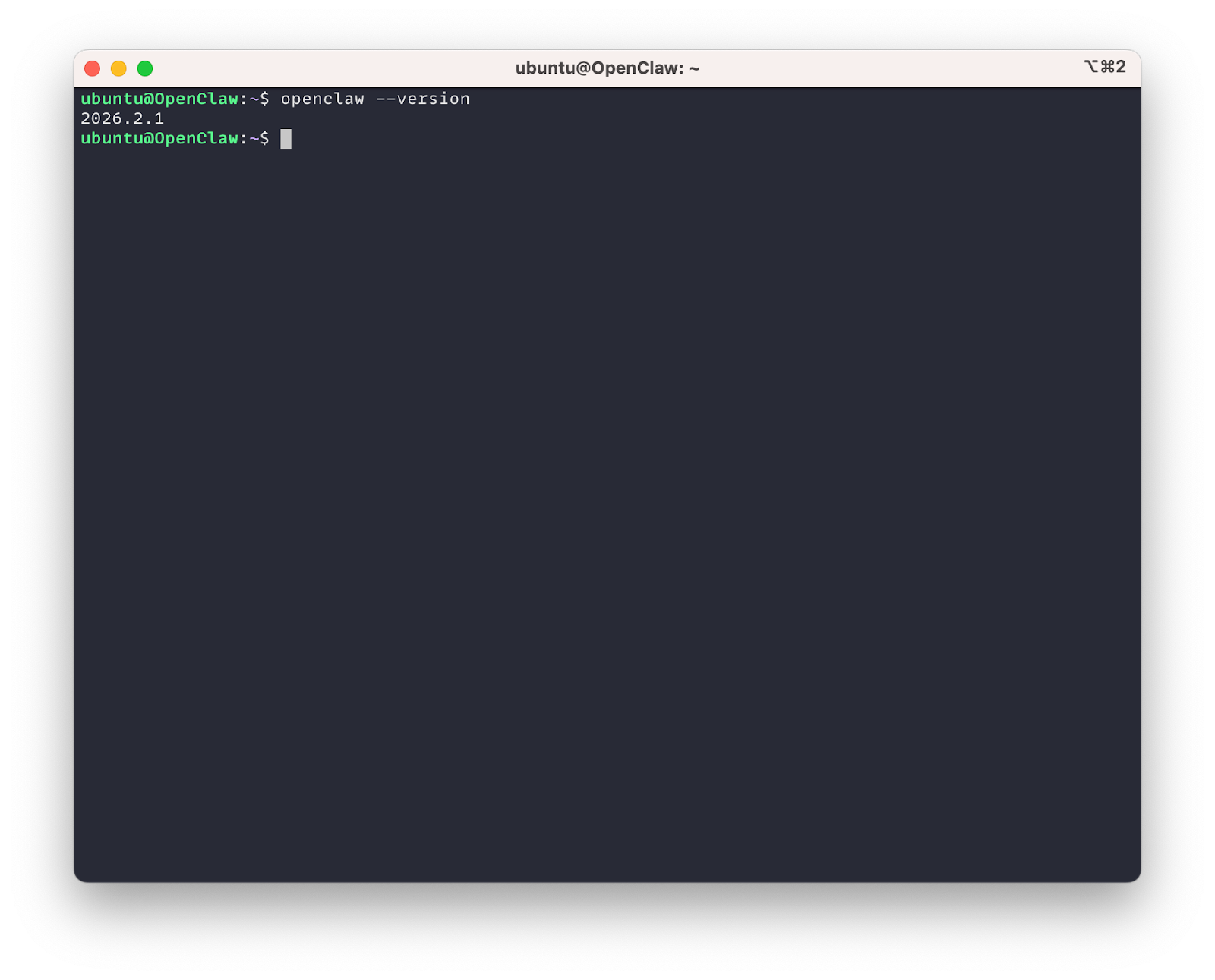

安装完成后,可通过以下命令验证是否安装成功:

openclaw --version

💡 常见问题提示

如果出现 openclaw: command not found 错误,请执行以下操作之一:

source ~/.bashrc # Or manually add to PATH if necessary export PATH="$HOME/.npm-global/bin:$PATH""

步骤三:配置 OpenClaw

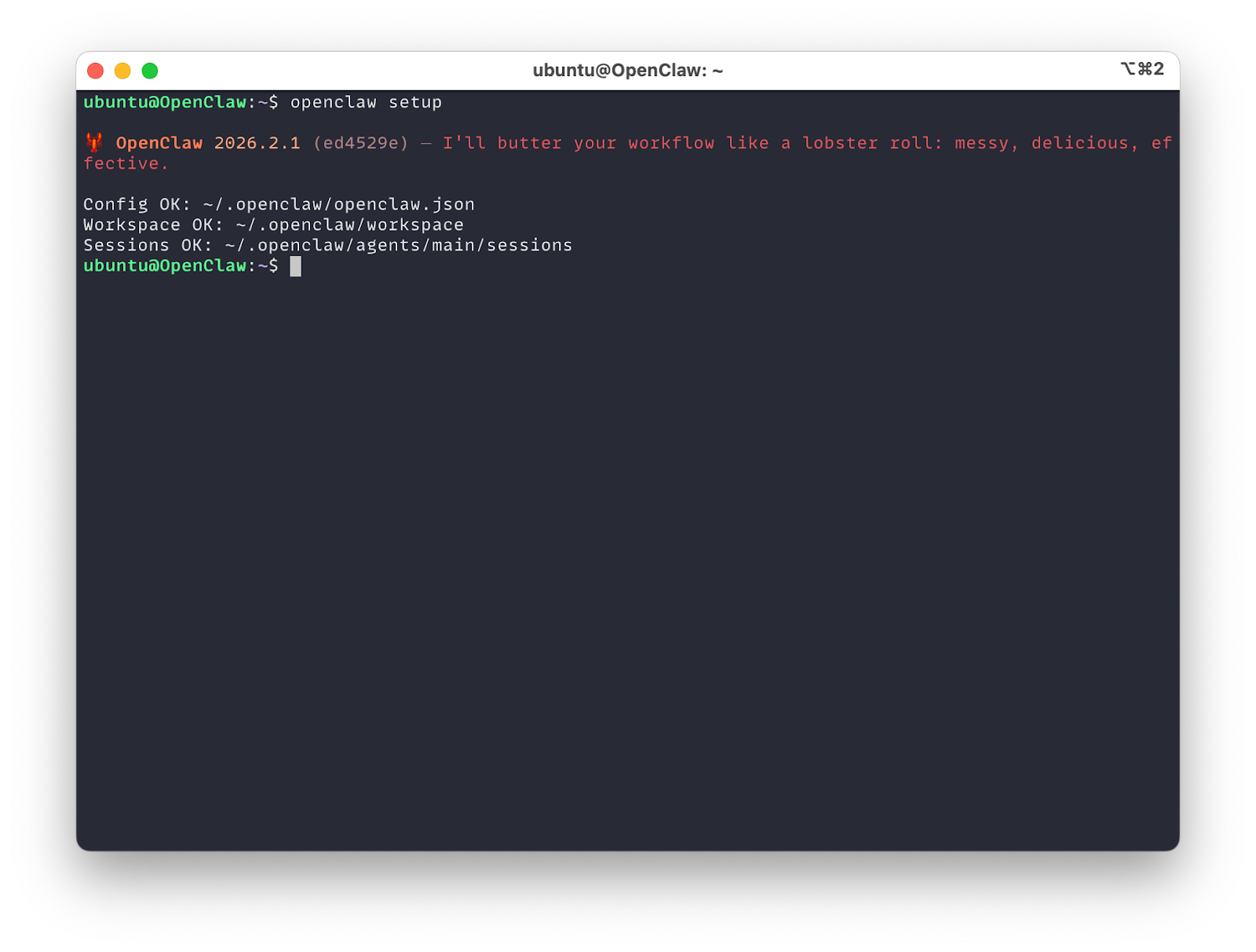

初始化配置

运行 OpenClaw 初始化向导,用于生成基础配置结构:

openclaw setup

该命令将在用户目录下创建默认的 OpenClaw 配置文件与工作目录。

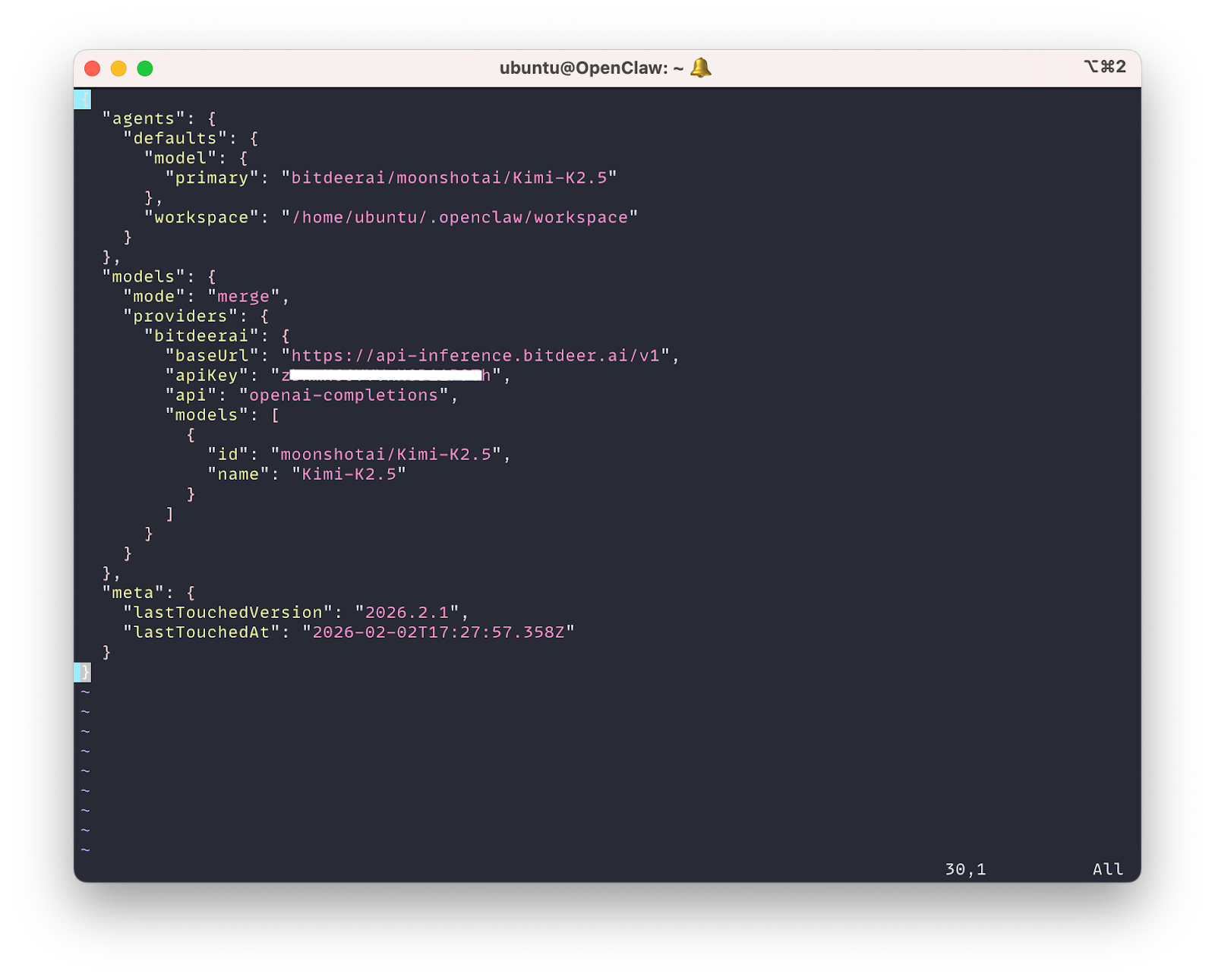

配置 AI 模型

完成初始化配置后,请编辑 OpenClaw 的配置文件以添加 AI 模型相关设置:

vim ~/.openclaw/openclaw.json

示例配置如下(仅展示关键部分):

{

"agents": {

"defaults": {

"model": {

"primary": "bitdeerai/moonshotai/Kimi-K2.5"

},

"workspace": "/home/ubuntu/.openclaw/workspace"

}

},

"models": {

"mode": "merge",

"providers": {

"bitdeerai": {

"baseUrl": "https://api-inference.bitdeer.ai/v1",

"apiKey": "your-api-key-here",

"api": "openai-completions",

"models": [

{

"id": "moonshotai/Kimi-K2.5",

"name": "Kimi-K2.5"

}

]

}

}

}

}

请将 your-api-key-here 替换为你自己的 Bitdeer API Key。

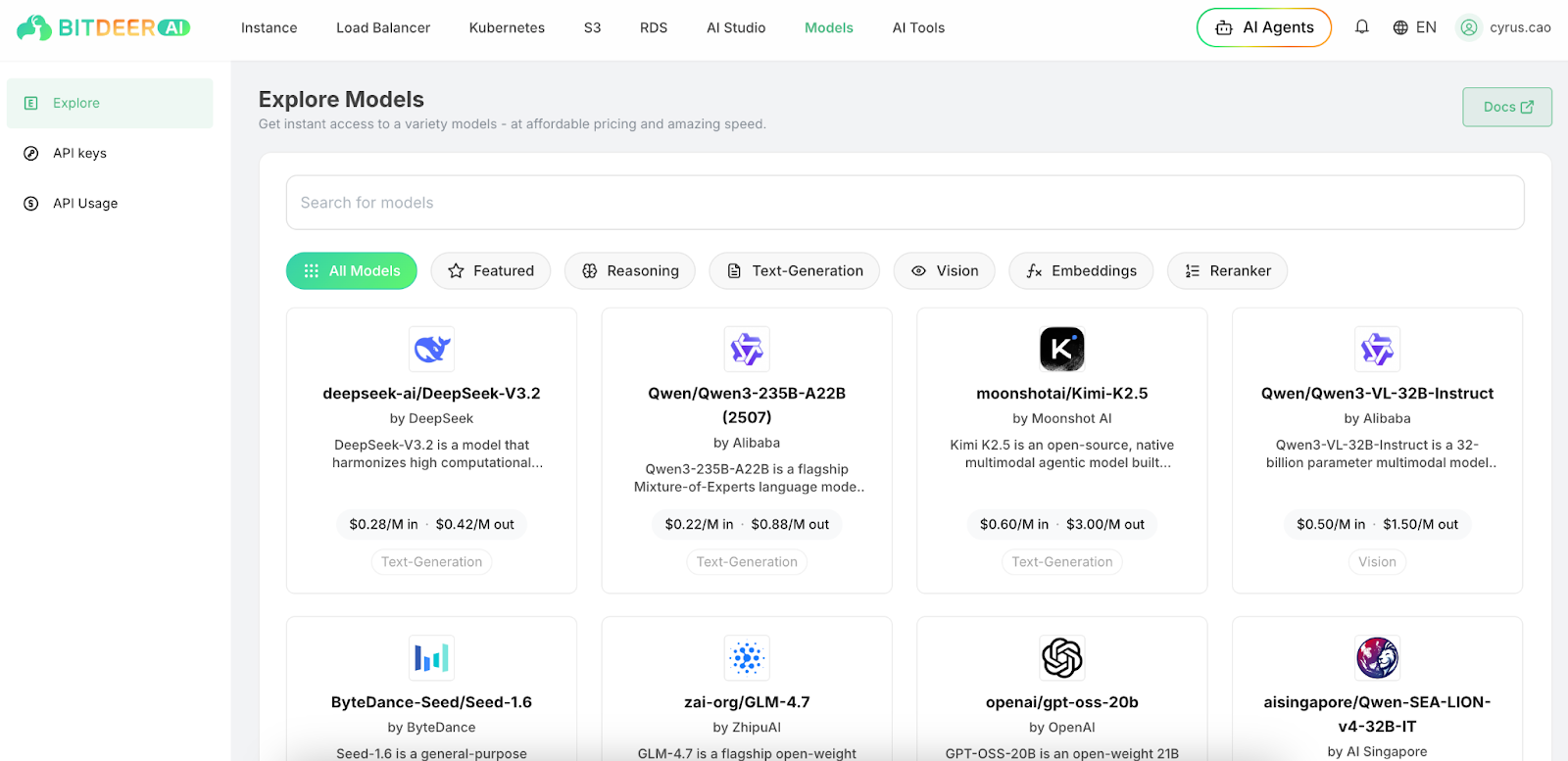

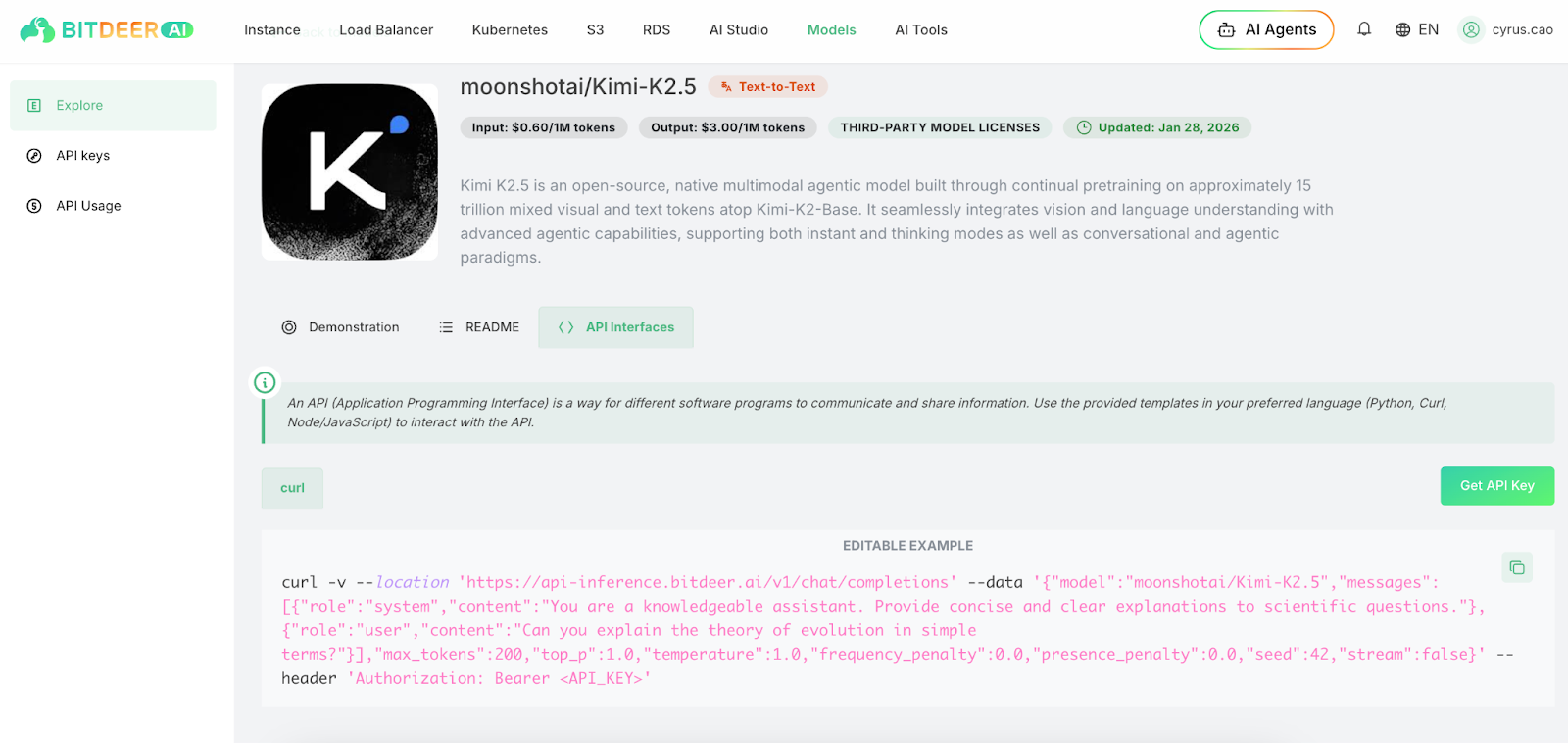

你可以在模型部分查看更多详情内容:

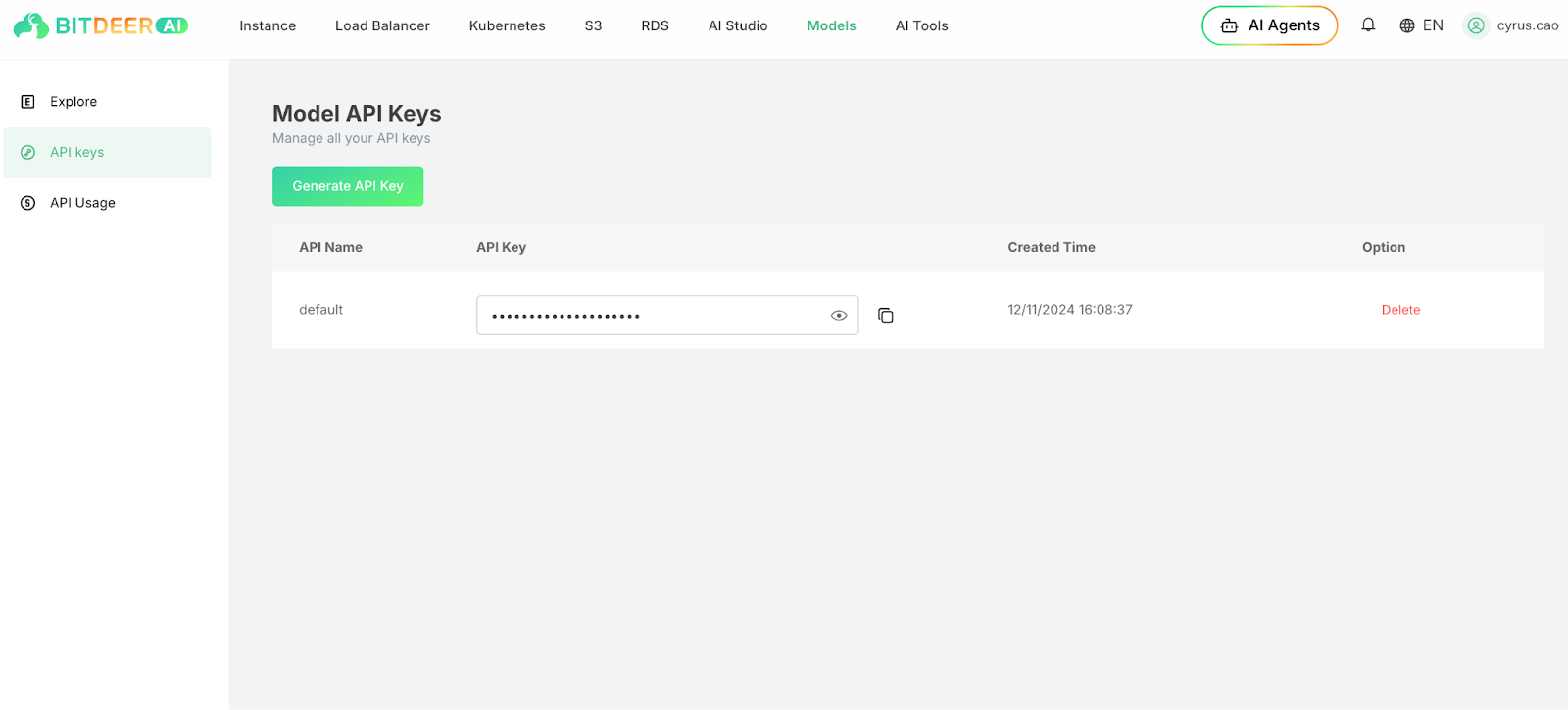

获取 Bitdeer AI Cloud API Key

获取 API Key 的步骤如下:

- 登录 Bitdeer AI Cloud 控制台

- 进入 Models → API Keys 页面

- 点击 Generate API Key

- 复制并妥善保存生成的 Key

⚠️ 重要提示:请勿将 API Key 提交到版本控制系统中。

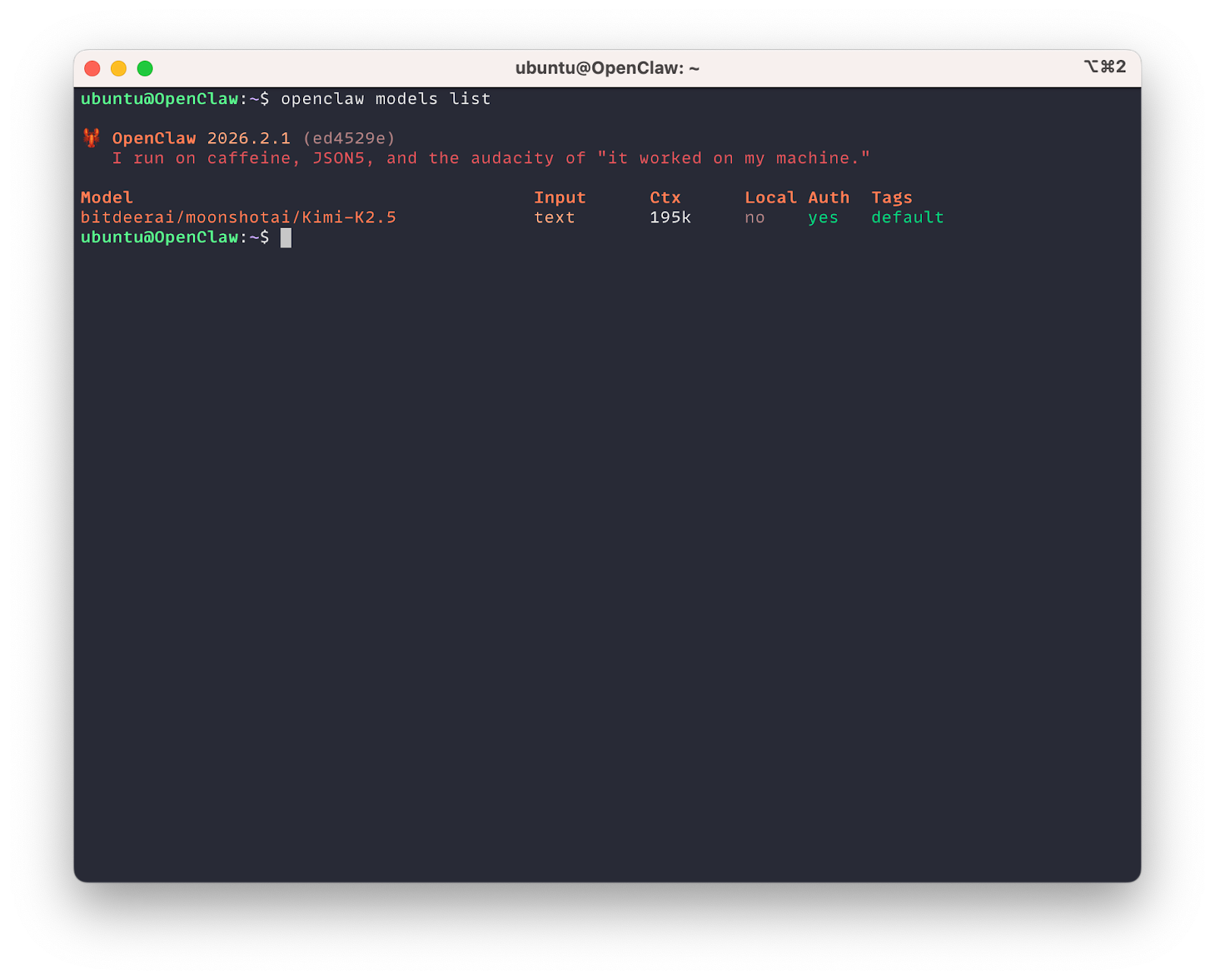

验证模型配置

完成模型配置后,可通过列出可用模型来验证配置是否正确:

openclaw models list

系统将返回当前已配置模型及其状态。

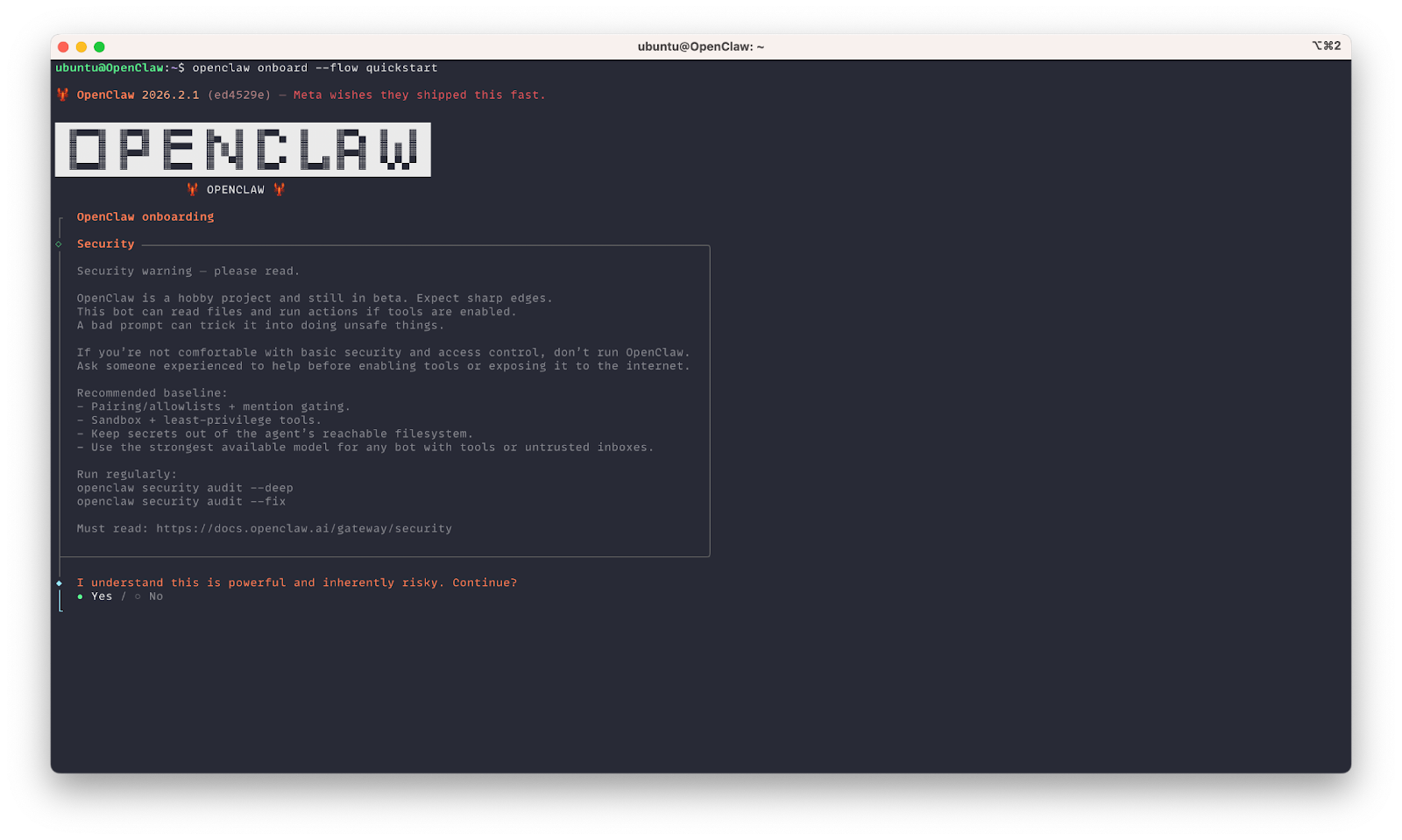

完成 Onboarding 流程

运行快速引导流程以完成 OpenClaw 服务初始化:

openclaw onboard --flow quickstart

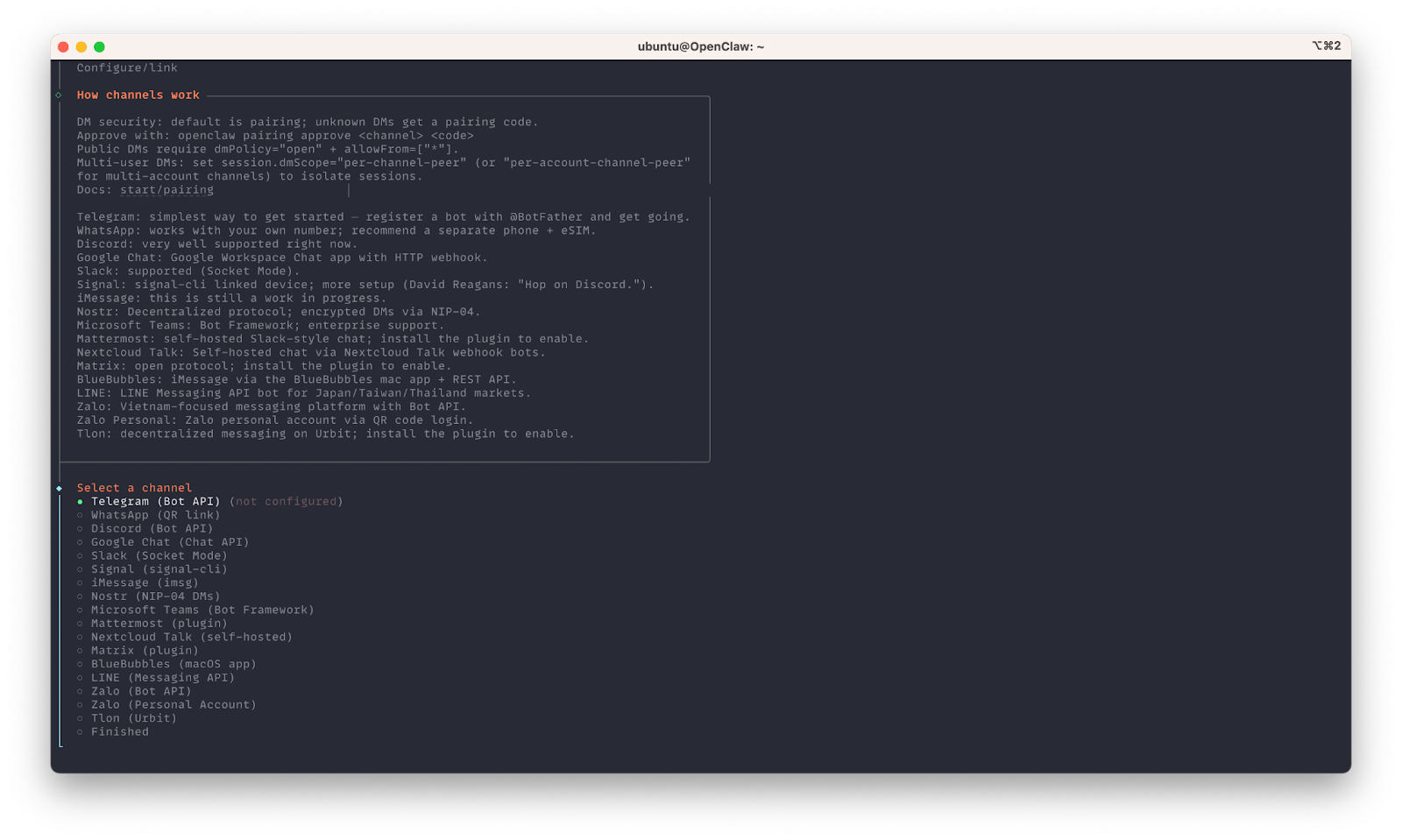

集成 Telegram

在引导过程中,请选择 Telegram 作为通信渠道,并输入你的 Telegram Bot Token。

完成后,OpenClaw 服务将自动在后台运行。

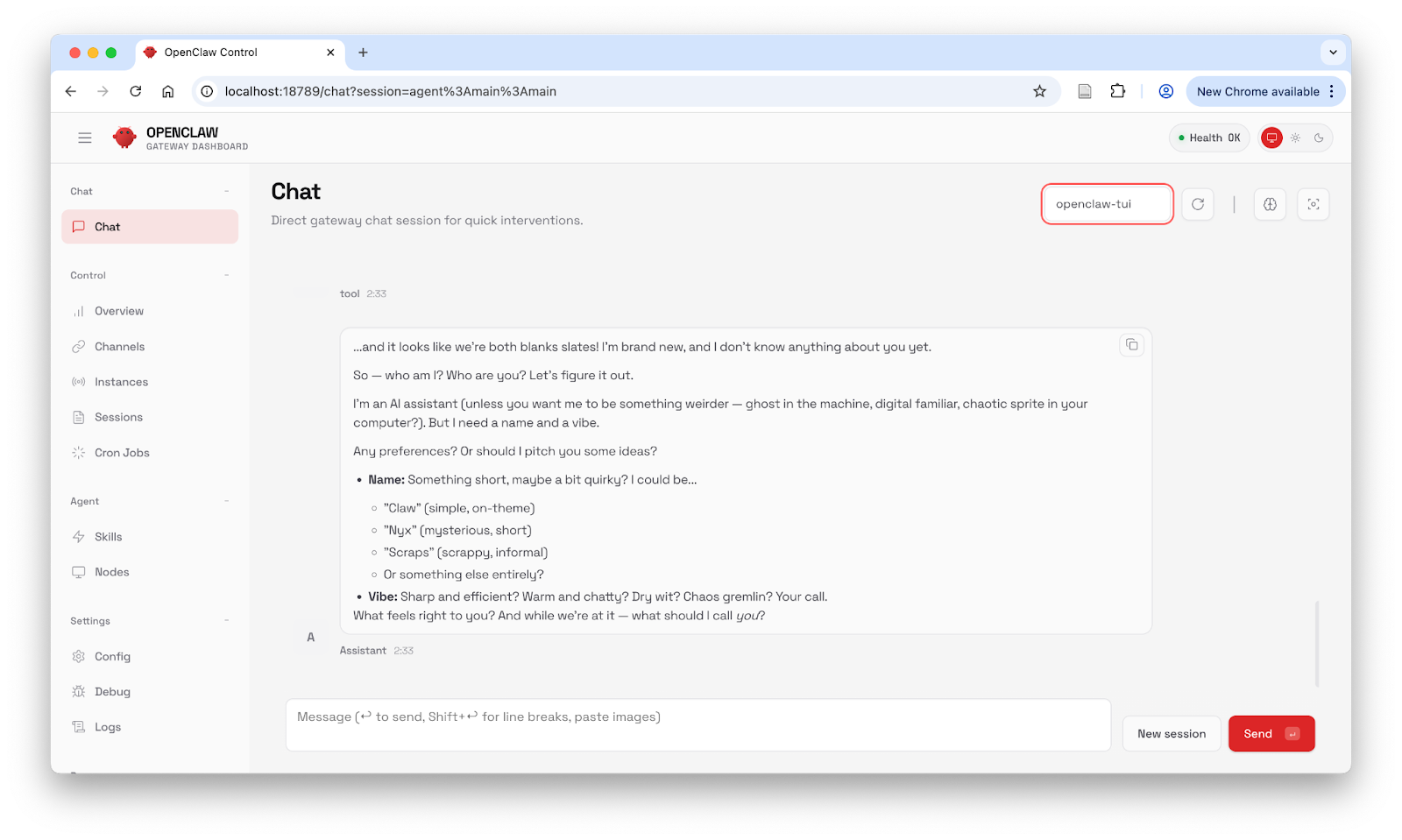

访问 OpenClaw 控制面板 (可选)

如果你希望通过 Web 界面访问 OpenClaw 控制面板,可以先建立一个 SSH 隧道,并使用网关令牌(gateway token)进行访问。

首先,请在配置文件中查找你的 gateway token:

cat ~/.openclaw/openclaw.json

示例配置段落:

{

"gateway": {

"mode": "local",

"auth": {

"mode": "token",

"token": "your-gateway-token"

},

"port": 18789

}

}

建立 SSH 隧道,在本地计算机上执行:

# Run this on your local machine

ssh -L 18789:localhost:18789 username@your-instance-ip

随后在浏览器中访问:

http://localhost:18789?token=your-gateway-token

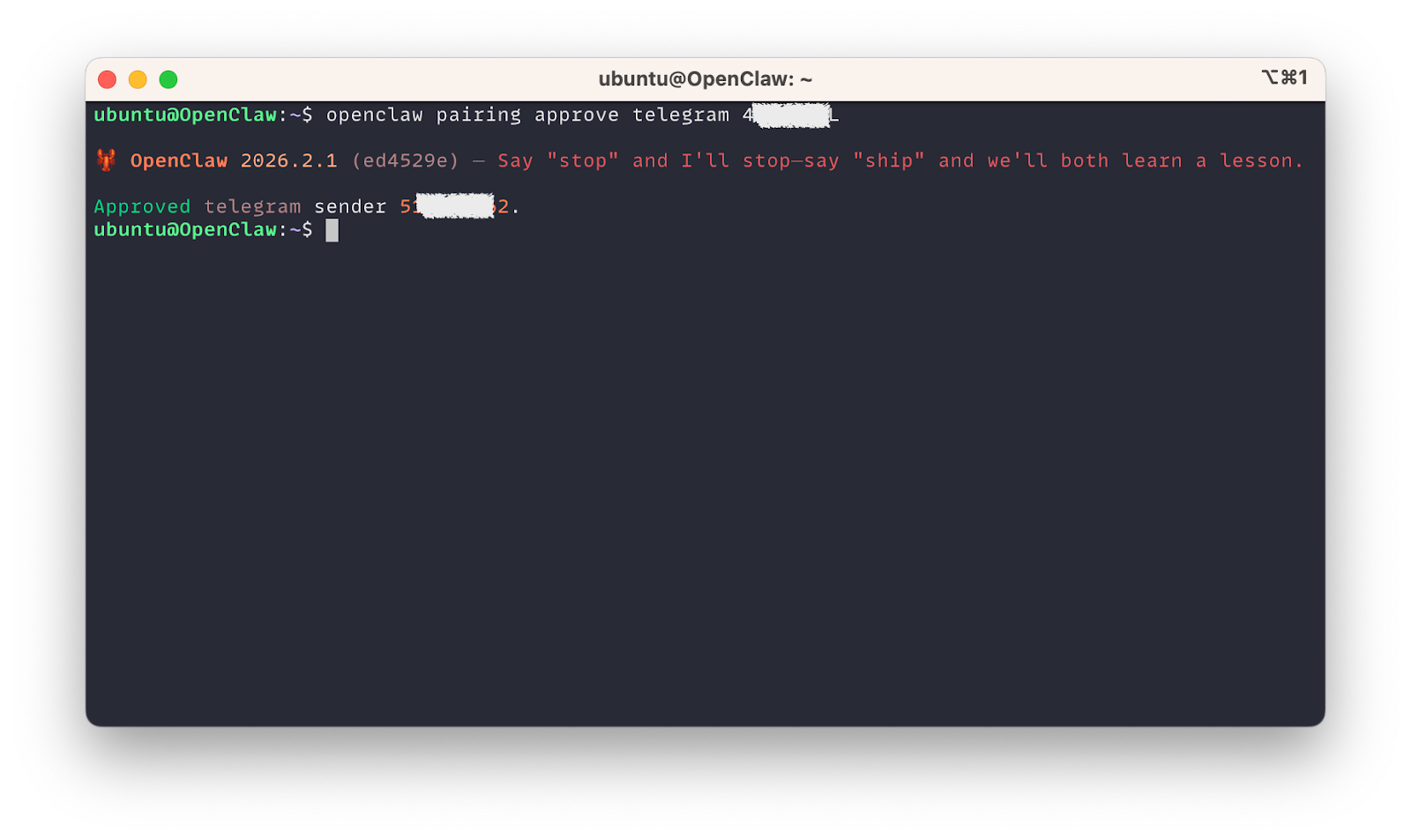

Step 4: 步骤四:与 Telegram 配对

绑定 Telegram 聊天

- 在 Telegram 中打开你的 Bot

- 发送 /start 命令

- Bot 将返回一个配对码

- 在服务器终端中执行:

openclaw pairing approve telegram <pairing-code>

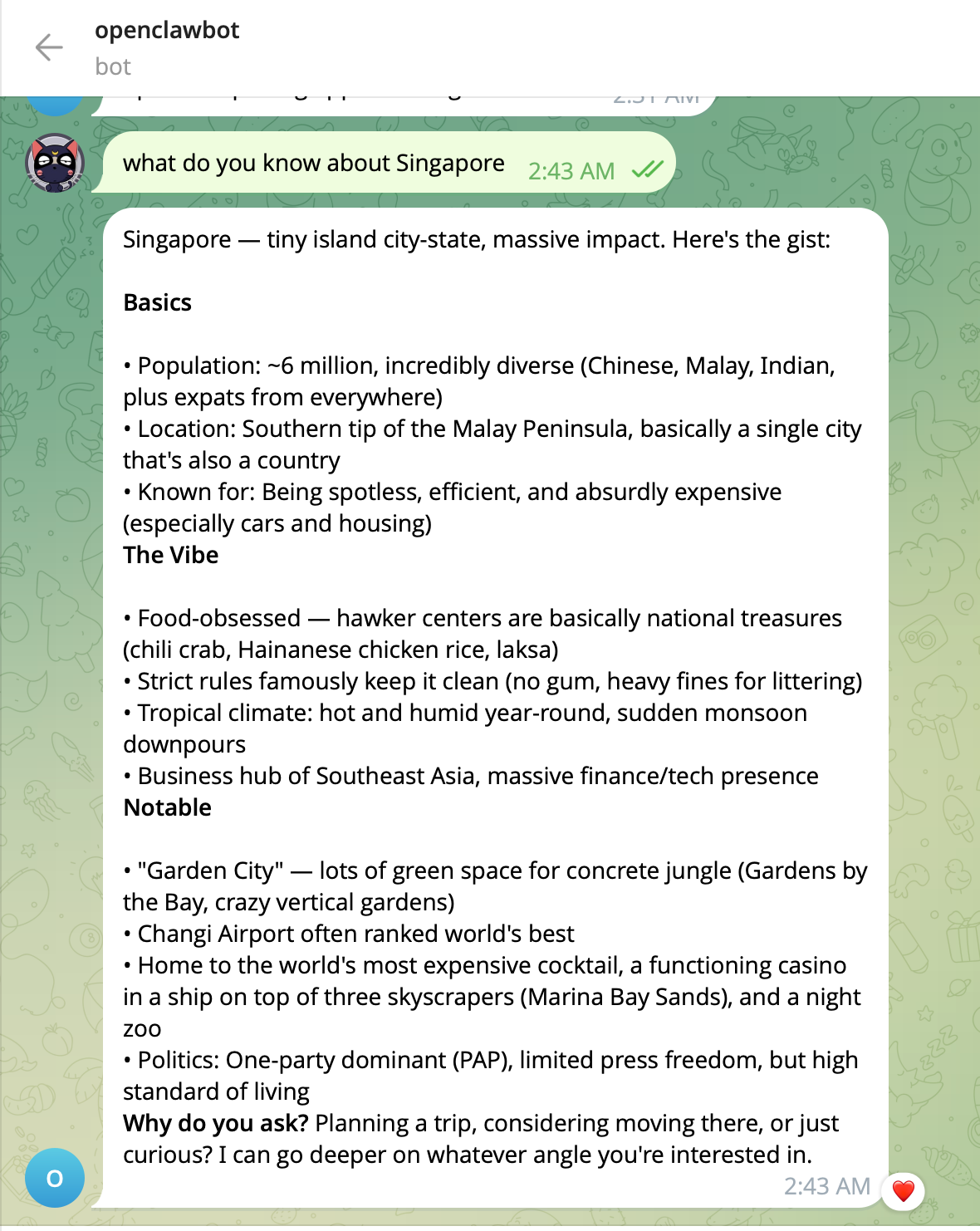

交互功能说明

配对成功后,Telegram Bot 可执行以下功能:

- 基于已配置模型回答问题

- 执行 Web 搜索

- 运行代码(沙箱环境)

- 处理文件上传

- 保持上下文对话状态

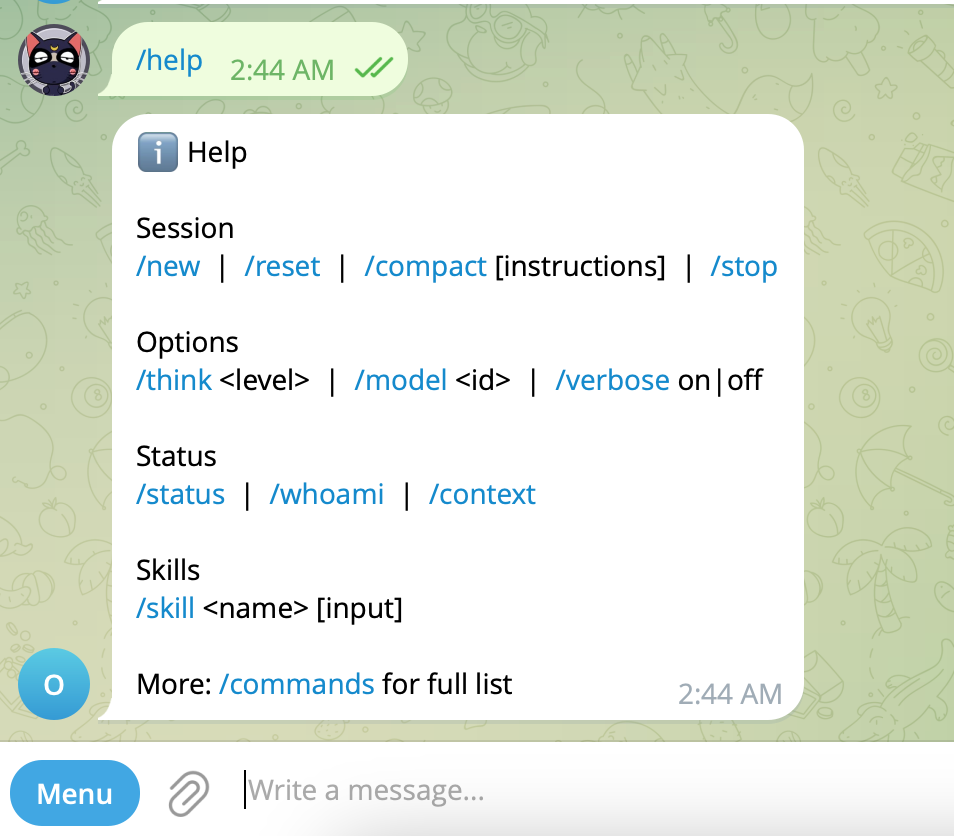

常用 Telegram 指令

- /start:初始化 Bot

- /help:显示可用指令

- /status:查看当前运行状态

总结

至此,你已在 Bitdeer AI Cloud 上成功部署并运行了一个功能完整的 OpenClaw AI 助手,并完成相关集成配置。该部署方案在保障安全性与性能的同时,提供了高度可定制的 AI Agent 能力,可支持多种实际业务场景与任务需求。

Bitdeer AI Cloud 稳定可靠的云端基础设施与 OpenClaw 灵活的 Agent 框架相结合,为智能助手的构建与部署提供了理想的运行环境。随着你对平台的进一步熟悉,还可以继续探索更高级的功能,例如更丰富的 Agent 能力扩展以及与其他交互渠道的集成。

祝您开发愉快,持续构建!

*安全提示:请对敏感操作配置适当的访问控制。