小型语言模型 vs 大型语言模型:能力、实用性与智能代理 AI 的未来

随着语言模型在现代 AI 应用中,尤其是在智能代理系统中,变得日益核心,对于“越大越好”的追求也引发了一个新的问题:小型模型是否能够提供更智能、更高效的替代方案?虽然大型语言模型(LLMs)因其广泛的能力而备受赞誉,但越来越多的证据表明,小型语言模型(SLMs)可能在可扩展性、成本效益和可持续性方面提供更优解,尤其适用于专注于特定或重复任务的智能代理。

本文将探讨 SLM 与 LLM 之间的基本差异、各自的优势,以及为何在智能代理 AI 的背景下,SLM 正受到越来越多关注。

定义:SLM vs LLM

在语言模型分类中,“小型”与“大型”之间没有绝对界限,但一个实用的区分标准可以依据部署占用的资源来确定:

- 小型语言模型(SLMs) 是针对特定领域或任务训练的语言模型,通常在效率和快速推理方面进行了优化,适用于特定场景。它们设计在资源需求较低的基础设施上运行,例如消费级 GPU 或边缘设备,因此非常适合对延迟敏感或受成本限制的环境。

- 大型语言模型(LLMs) 则在广泛、多样的数据集上进行训练,以处理各种通用语言任务。这类模型通常需要数据中心级别的基础设施进行训练和推理,适合需要开放式推理、广泛知识覆盖和多领域适应性的应用。

本质上,SLM 注重专业化与效率,而 LLM 强调通用性与规模,两者在不断发展的 AI 生态中承担不同角色。尽管存在这些差异,它们共享相同的基础架构与目标:有效理解和生成自然语言,为智能应用提供支持。

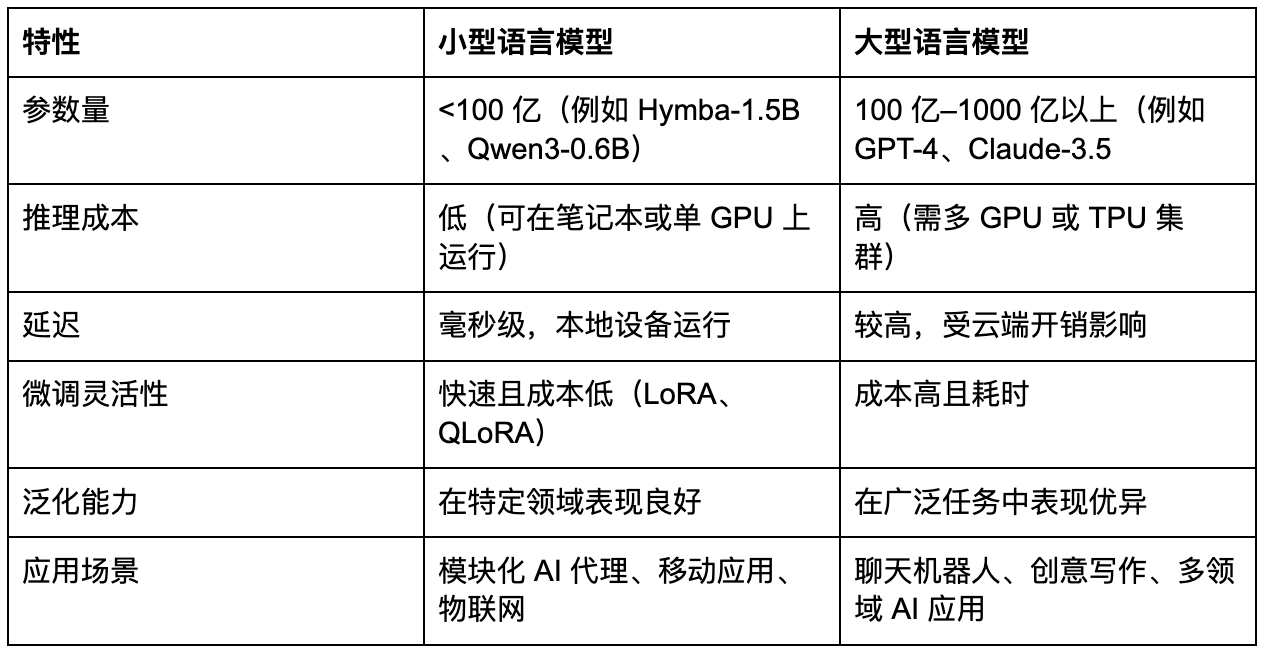

因目前尚无统一标准,本文暂且采用 NVIDIA 的定义:截至 2025 年,大多数参数量少于 100 亿的模型可被视为 SLM,其余则自然归类为 LLM[1]。下表总结了 SLM 与 LLM 的关键特性对比。

推理性能:小型语言模型(SLMs)够用吗?

得益于架构创新和训练策略,如今的 SLM 在许多任务上已经能够与上一代大型语言模型(LLMs)相媲美。NVIDIA 论文中引用的基准测试显示:

- Phi-2(2.7B) 在推理和编程任务上的表现可与 30B 模型相当 [1]。

- NVIDIA Hymba-1.5B 在遵循指令的准确性上超过了 13B 的 LLM [1]。

- Huggingface 的 SmolLM2 系列模型(125M–1.7B) 在语言理解能力上可与更大规模的模型相媲美 [1]。

这一点尤为引人关注的原因在于智能代理 AI 的特性:大多数任务涉及可预测的、狭窄领域,例如解析邮件、安排日程、文本摘要或调用 API。对于这些工作流程,体积小、专门化的模型往往比单一的大型通用模型更高效 [1]。

市场趋势:SLM 与向智能代理 AI 的转变

全球小型语言模型(SLM)市场预计将从 2025 年的 9.3 亿美元增长至 2032 年的 54.5 亿美元,复合年增长率达到 28.7%(MarketsandMarkets)。这一增长反映了对高效 AI 模型日益增长的需求,尤其是在能够本地运行的环境中,如智能手机、传感器和嵌入式系统。

随着 AI 代理在实时和隐私敏感型应用中得到更广泛的使用,SLM 为大型模型提供了切实可行的替代方案。它们能够以低延迟和较低的基础设施要求执行专门任务,非常适合可扩展且自适应的智能代理架构。

小型语言模型在 AI 代理架构中使用

AI 代理越来越依赖语言模型来管理结构化工作流,从输入解析到工具协调。虽然大型模型在开放式推理方面表现出色,但许多代理任务具有狭窄、重复和时间敏感的特点,因此更适合使用小型语言模型(SLMs)。

SLMs 可以针对特定子任务进行微调,并以更低的延迟和成本部署。它们的高效性和适应性使其非常适合模块化的代理设计,尤其是在性能、可控性和规模至关重要的商业场景中。

小型语言模型(SLMs)非常适合需要速度、可预测性以及领域特定推理的商业场景。在以下部分,我们将探讨 SLM 在各行业中的实际应用案例,展示其解决实际问题的方式。 以下是一些 SLM 明显具备优势的实际应用案例:

- 客户服务自动化

- 根据意图或紧急程度对支持工单进行分类

- 从自由文本输入中填写结构化表单

- 为常见查询生成一致且格式化的回复

- 金融服务

- 从文件中提取 KYC(了解您的客户)信息

- 实时标记和注释交易记录

- 对合规文件进行摘要,同时保持严格的格式要求

- 零售与电商

- 通过聊天机器人处理产品咨询和订单状态更新

- 在店内边缘设备上进行价格或库存查询

- 使用快速、可离线运行的代理自动回复常见问题

- 医疗与法律

- 对临床记录或法律合同进行摘要

- 在存储或共享前对敏感信息进行脱敏处理

- 对结构化文档中的条款或章节进行分类

SLMs 与 LLMs 的发展前景

未来并非是 SLM 与 LLM 之间的零和竞争。相反,我们更可能看到:

- LLM 继续在云端驱动高风险、开放域的推理任务。

- SLM 在边缘、移动及嵌入式场景中占据主导地位,并形成大部分智能代理调用的核心 [1]。

语言模型部署的趋势,并不是小模型与大模型的竞赛,而是朝着智能化、目标明确的协调发展。LLM 在需要知识广度和上下文深度的复杂任务中仍然发挥着至关重要的作用,尤其是在云端。然而,SLM 正逐渐成为大多数贴近用户的智能代理操作的实用引擎,提升响应速度,并降低对集中计算的依赖。

随着智能代理 AI 越来越个性化、分布化,并融入日常工作流,对快速、可适应且高效模型的需求将持续增长。届时,SLM 将不仅仅是轻量级的替代方案,而将成为下一代智能系统的基础构建模块。

Bitdeer AI 能为您提供什么?

即便您具备运行轻量型 SLM 工作负载的能力,也可将复杂推理任务交给我们处理。Bitdeer AI 提供可扩展、高性能的基础设施,用于部署和服务基础模型,尤其适用于在云端、混合环境及企业环境中运行的大型语言模型(LLMs)。通过预先容器化的模型服务、优化的 GPU 集群,以及对 LLaMA 3、Mistral、DeepSeek 等主流开源模型的支持,Bitdeer AI 帮助开发者和企业显著缩短推理时间,同时降低 AI 工作负载管理的复杂度。

我们的平台覆盖 AI 生命周期的全流程:从模型探索与原型开发,到微调与多节点部署,再到满足低延迟要求的实时推理。凭借模块化、智能代理就绪的架构,以及与现代 MLOps 技术栈的高度兼容性,Bitdeer AI 使企业能够构建灵活、高可靠的生产级 AI 系统,满足金融、客户服务、科研等多领域的应用需求。

结语

SLM 与 LLM 各自在 AI 生态系统中发挥着独特价值。随着复杂智能代理应用的出现,尤其是那些必须在边缘运行或经济高效扩展的场景中,小型模型提供了一种兼具能力与实用性的解决方案。

尽管 SLM 的兴起值得关注,LLM 仍然是首选,因为它能够提供更广泛、更全面的知识来应对多样化任务。在智能代理 AI 的开发中,最有效的策略是将二者结合:LLM 提供总体推理与上下文理解,而 SLM 则在效率、适应性和特定任务敏捷性方面展现优势。这种互补策略使 AI 系统在实际应用中既能实现规模化,又能保持高水平的智能化。

引用:

[1] Peter Belcak et al., Small Language Models are the Future of Agentic AI, arXiv:2506.02153v1, June 2025. https://arxiv.org/abs/2506.02153