传统数据中心 vs AI 数据中心:基础设施差异解析

数据中心始终反映着其所处时代的主流计算范式。长期以来,企业软件、Web 服务以及数据库系统主导了数据中心的设计与运营方式。这类工作负载强调可靠性、稳定性能以及高效的资源共享。

人工智能的兴起带来了截然不同的需求特征。现代 AI 系统的训练与部署需要大规模并行计算、快速的数据传输能力以及显著更高的功率密度。因此,在传统数据中心之外,一种新的基础设施形态逐渐成型,AI 数据中心。本文将系统性地分析传统数据中心与 AI 数据中心在架构设计、应用场景及商业价值方面的差异。

什么是传统数据中心?

传统数据中心旨在支持多样化的通用计算工作负载,其架构设计以灵活性和整体运行稳定性为核心目标。

其主要特征包括:

- 以 CPU 为核心的计算架构,适合顺序型和事务型处理

- 中低功率密度,通常可通过风冷方式满足散热需求

- 通用型网络架构,主要面向客户端到服务器的通信模式

- 多租户工作负载支持,常通过虚拟化技术实现资源隔离与调度

这一模式至今仍非常适合企业信息系统、Web 平台以及对稳定性和高可用性要求较高的关键业务应用。

什么是 AI 数据中心?

AI 数据中心是专为机器学习和人工智能工作负载而设计的基础设施,其核心不再是通用处理器,而是各类计算加速器。

其关键特征包括:

- 以 GPU 或 AI 加速器为核心的计算集群,支持大规模并行计算

- 极高的功率与热密度,需要更先进的散热方案

- 高带宽、低延迟的互连网络,以支撑密集的数据交换

- 计算、存储与网络的深度集成,以减少系统瓶颈

AI 数据中心并非同时承载大量彼此无关的工作负载,而是被优化用于高效运行数量较少但计算强度极高的任务。与传统数据中心普遍采用的标准以太网不同,AI 数据中心通常采用专用的 InfiniBand 或 RoCE(基于融合以太网的 RDMA)网络架构,以确保网络不会成为 GPU 性能发挥的瓶颈。

数据中心机房等级划分:Tier I、Tier II 与 Tier III

在比较传统数据中心与 AI 数据中心之前,有必要先了解业内常用的数据中心机房等级体系。Tier 等级主要用于衡量数据中心在可靠性、冗余能力和可维护性方面的设计水平,而非计算性能本身。

Tier I 数据中心

Tier I 是最基础的数据中心等级,通常采用单一路径的供电与制冷架构,几乎不具备冗余能力。无论是计划内维护还是突发故障,通常都需要整体停机。该等级适用于对可用性要求较低的非关键业务场景。其预期可用性为 99.671%(每年约 28.8 小时的停机时间)。

Tier II 数据中心

Tier II 在 Tier I 的基础上增加了有限的冗余设计,例如备用电源或冗余制冷设备。但整体系统仍以单一路径为主,因此在维护或切换过程中仍可能影响业务运行。Tier II 通常适用于对稳定性要求中等的业务负载。其预期可用性为 99.741%(每年约 22 小时的停机时间)。

Tier III 数据中心

Tier III 数据中心具备可维护性冗余能力,关键基础设施通常采用 N+1 冗余设计,并支持多路径供电与制冷。其特点是在不中断业务运行的前提下,可对单个系统组件进行维护或更换。Tier III 是当前企业级与云计算数据中心中广泛采用的等级,也更适合承载关键业务及多数 AI 工作负载。其预期可用性为 99.982%(每年约 1.6 小时的停机时间)。

需要注意的是,Tier 等级衡量的是基础设施的可靠性水平,并不直接决定是否适合 AI 工作负载。AI 数据中心通常在 Tier III 或更高可靠性等级的基础上,进一步强化高密度供电能力、散热方案以及面向加速计算的系统设计。

架构与运维分析

传统数据中心与 AI 数据中心之间的架构差距正在迅速扩大。CPU 以通用性见长,但 AI 工作负载需要在成千上万个相同运算上实现并行执行。GPU 和 AI 加速器弥补了这一能力缺口,同时也引入了新的基础设施约束。

AI 数据中心必须重点解决以下问题:

- 供电能力挑战:高密度机柜对电力需求大幅提升

- 散热管理难题:单纯依赖风冷已难以满足需求

- 网络拥塞风险:模型训练高度依赖 GPU 之间的持续通信

- 数据局部性要求:需要确保存储与计算资源紧密耦合

在运维层面,管理重心也从单台服务器或虚拟机,转向以集群为整体的系统管理。效率评估不再仅依赖资源利用率,而更多关注训练时间、推理延迟以及能效表现。

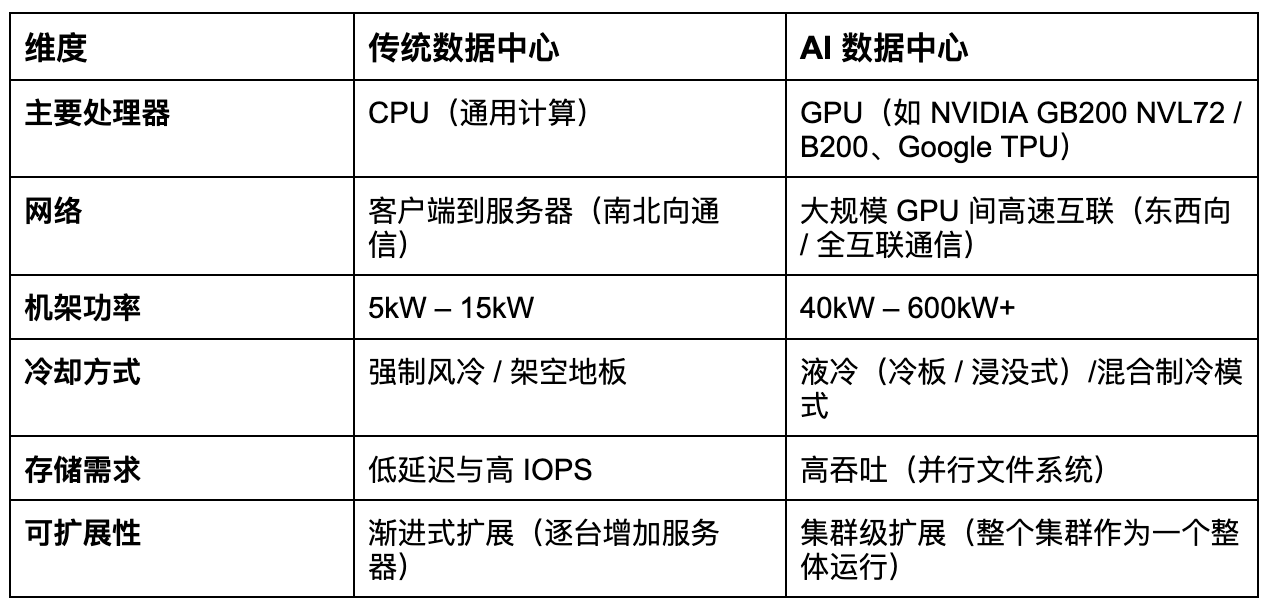

以下是传统数据中心与AI 数据中心之间的关键对比:

业务应用与行业影响

AI 数据中心正迅速成为现代企业获取竞争优势的核心基础。它们使组织能够从零散的 AI 实验,迈向大规模模型训练、高吞吐推理,以及用于自动化客户支持、软件开发和数据分析等复杂工作流程的 AI 智能体。计算能力、数据传输能力以及功率密度的可扩展性,直接影响创新速度和产品上市周期。

在各行各业中,AI 数据中心正在重塑价值创造方式。金融机构利用其进行实时风险建模和欺诈检测,医疗机构将其应用于先进的医学影像和诊断,制造企业则依托其开展仿真计算、数字孪生和预测性维护。这些由 AI 驱动的工作负载正从探索性应用,逐步演变为关键业务系统。

随着 AI 应用的加速普及,企业正将基础设施战略围绕 AI 数据中心进行重构,将其视为长期的战略性资产。AI 数据中心不再只是支撑系统,而是逐渐成为推动创新、提升运营效率和塑造竞争优势的核心引擎,决定着组织在业务层面扩展智能能力的速度与成效

总结

随着 AI 系统在规模和复杂度上的持续提升,基础设施决策已不再只是技术层面的选择,而是上升为战略层面的考量。将云平台的灵活性与专为 AI 打造的数据中心设计相结合,正成为组织实现先进 AI 稳定、高效部署的关键能力。

在 Bitdeer AI,我们正是基于这一现实来构建云平台。通过整合集团层面的全球基础设施资源,包括利用现有的数据中心站点和电力资源优势,并与灵活的云能力相结合,我们打造了一套专为先进 AI 工作负载而设计的 AI 云基础,全面支持基于新一代 NVIDIA GPU 的高性能计算。这种一体化模式在保障性能、能效和运行韧性的同时,实现了 AI 的规模化部署,使客户能够专注于智能能力的构建与落地,而底层 AI 基础设施的复杂性则由我们以安全、可持续、可规模化的方式统一管理。