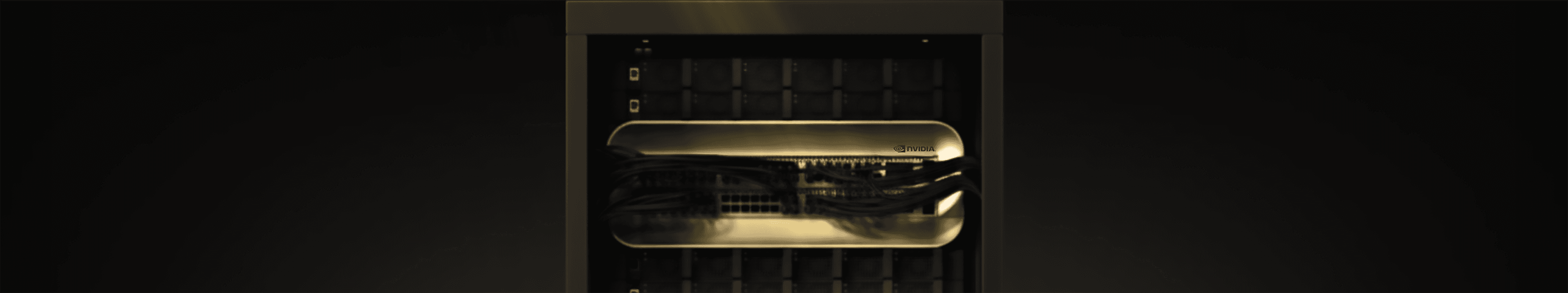

NVIDIA GB200 NVL72

加速AI规模驱动智能回报

算力无限,创新无界。NVIDIA GB200 NVL72以卓越性助力您实现更高AI回报 — 立即使用,引领智能变革。

赋能下一代人工智能与加速计算

大语言模型推理

30倍

相比 NVIDIA H100 Tensor Core GPU

突破性的训练与推理效率

相比上一代,推理速度提升高达30倍,训练周期显著缩短。

大语言模型训练

4倍

相比 H100

高带宽、低延迟互联

130 TB/s的NVLink带宽贯通GPU和CPU,支持大规模分布式训练和多节点工作负载。

能源效率

25倍

相比 H100

可持续液冷设计

先进的液冷技术降低能耗和运营成本,同时支持大规模密集部署。

数据处理

18倍

相比 CPU

海量内存容量

搭载HBM3e,内存容量以TB计量,极致带宽可处理万亿参数模型和长上下文推理。

通向下一代性能之路

探索NVIDIA GB200 NVL72的幕后故事,每一步都体现了驱动AI基础设施未来的创新、精准和规模。

重新定义AI基础设施

进入Blackwell时代

扩展企业AI模型

缩短基础模型和领域专用LLM的上市时间。NVIDIA GB200 NVL72加速训练和微调,帮助企业更快部署有竞争力的AI产品。

大规模驱动AI代理

支持企业级AI副驾驶和助手的实时推理和长上下文推理。让员工和客户即时、可靠地获得智能支持。

驱动多模态应用

运行结合文本、图像、视频和音频的高级应用。NVIDIA GB200 NVL72提供智能搜索、合规自动化和更丰富客户体验所需的性能和带宽。

加速数据密集型决策

近乎实时处理海量数据集,用于预测、风险分析和场景规划。企业可以通过AI驱动的洞察做出更快、更自信的决策。

应用场景

金融与银行业

以超低延迟和高吞吐量加速风险建模、欺诈检测和算法交易,实现更快、更准确的决策。

医疗与生命科学

利用TB级内存和FP64性能加速药物研发、基因组分析和医学影像,缩短研究周期并改善结果。

制造与工业工程

利用液冷、高能效集群支持数字孪生、预测性维护和生成式设计,提升生产力并减少停机时间。

零售与客户体验

部署大规模AI副驾驶、推荐引擎和个性化系统,提供实时洞察和无缝客户互动。

NVIDIA GB200 NVL72技术规格

NVIDIA GB200 NVL72

NVIDIA GB200 NVL72 Grace Blackwell超级芯片

Configuration

36 Grace CPU : 72 Blackwell GPUs

1 Grace CPU : 2 Blackwell GPU

FP4 Tensor Core1

1,440 PFLOPS

40 PFLOPS

FP8/FP6 Tensor Core1

720 PFLOPS

20 PFLOPS

INT8 Tensor Core1

720 POPS

20 POPS

FP16/BF16 Tensor Core1

360 PFLOPS

10 PFLOPS

TF32 Tensor Core

180 PFLOPS

5 PFLOPS

FP32

5,760 TFLOPS

160 TFLOPS

FP64

2,880 TFLOPS

80 TFLOPS

FP64 Tensor Core

2,880 TFLOPS

80 TFLOPS

GPU Memory | Bandwidth

Up to 13.4 TB HBM3e | 576 TB/s

Up to 372GB HBM3e | 16 TB/s

NVLink Bandwidth

130TB/s

3.6TB/s

CPU Core Count

2,592 Arm® Neoverse V2 cores

72 Arm Neoverse V2 cores

CPU Memory | Bandwidth

Up to 17 TB LPDDR5X | Up to 18.4 TB/s

Up to 480GB LPDDR5X | Up to 512 GB/s

1 - 启用稀疏性

常见问题

NVIDIA GB200 NVL72 集群现已在 Bitdeer AI Cloud 正式上线并开放使用,您可立即部署并规模化运行 AI 工作负载。

预订NVIDIA GB200 NVL72可能需要支付定金。请咨询我们的销售团队以了解详情和灵活安排。

NVIDIA GB200 NVL72超越H100和H200,在一个机架中集成72个Blackwell GPU,提供无与伦比的性能、带宽和效率。它在GPT规模万亿参数模型上的训练速度提升高达30倍,能效比H100提升4倍以上,是大规模AI、HPC和多代理工作负载的首选。

NVIDIA GB200 NVL72在万亿参数训练、实时推理、多代理AI、HPC模拟和大规模数据分析方面表现卓越。

对于现有Bitdeer AI用户,工作负载和数据可以顺利扩展到NVIDIA GB200 NVL72,只需最少的更改。新用户将获得全面支持,确保更快、更简单的迁移。

通过机架级液冷和优化的电力传输管理电力和冷却,确保高效率、密集部署和大规模稳定性能。

用NVIDIA GB200 NVL72驱动您的AI

获得无与伦比的性能和规模

即刻驱动业务增长

比特小鹿科技集团(Straitdeer Pte. Ltd.)是 NVIDIA 云计算的优选合作伙伴。

通过行业标准认证并广受信赖

(ISO/IEC 27001:2022 和 SOC2 Type I & Type II)